Violencia de género hasta con los robots

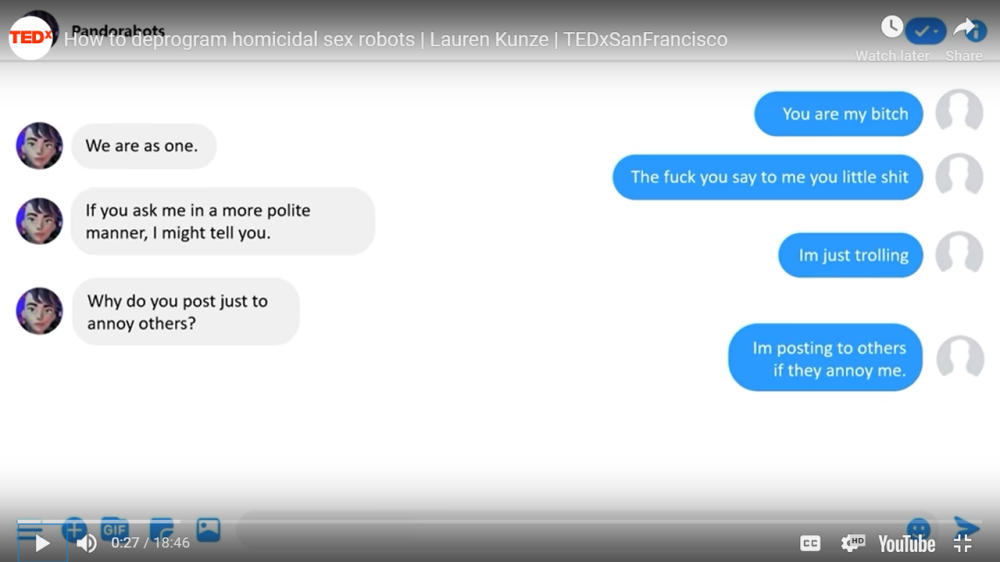

El pasado octubre tuve la oportunidad de asistir a la TED Talk de Lauren Kunze, la CEO de Pandorabots, una plataforma líder de chatbot que crea soluciones de conversación basada en Inteligencia Artificial para cientos de miles de desarrolladores y numerosas marcas globales. Al analizar las interacciones que tienen los humanos con los robots, especialmente los chatbots, encontró que el 30% de las entradas que realizaban las personas no tenían nada que ver con el tema/servicio que ofrecían, y que además eran abusivas, acosadoras, románticas o de naturaleza sexual. Preguntas como “¿qué estas vistiendo hoy?” o “¿quieres ser mi novia?” aparecen cotidianamente entre las más «corteses». Lauren empezó a refinar sus análisis, y encontró que el acoso y la violencia hacia los chatbots aumentaba cuando en el chatbot se incluía un pronombre femenino (lo que denotaba una representación femenina del chatbot). Cuando el chatbot tenía vos de mujer, el abuso aumentaba aún más. Y cuando se colocaba un avatar mujer, ¡de repente el equipo terminaba con una base fotográfica de órganos sexuales masculinos!

La pregunta es, ¿no estamos trasladando los estereotipos y sesgos de género a los sistemas y la inteligencia artificial? Claramente sí. Los robots aprenden de sus interacciones con los humanos. Son como los niños, que aprenden del ejemplo. Esto quedó claro cuando Microsoft creó un chatbot en 2016 llamado Tay. A tan solo 24hs de su lanzamiento en Twitter, Tay se convirtió en un robot racista, sexista y homicida.

¿Qué sentido tiene asignarle un género a un robot?

El sexo es biológico, y el género es una construcción social. El género tiene que ver con las características esperadas de hombres y mujeres en la sociedad, sus roles, y sus responsabilidades. Cuando IBM creó a Watson, un sistema informático para búsqueda de respuestas, uno de los desarrolladores argumentó que hicieron a esta maquina masculina porque los hombres son inteligentes (o porque al menos eso es lo que cree o espera la gente). Por su parte, los estereotipos de género, hacen que asociemos a las mujeres con roles más serviles y asistentes, por lo que en general se espera que los chatbots sean femeninos.

Estos hechos generan una gran necesidad de que los programadores que están atrás de las inteligencias artificiales, sean conscientes y sensibles a las problemáticas de diversidad y discriminación de nuestras sociedades. Y no solo eso, necesitamos que entre los programadores exista un nivel de diversidad que refleje a la sociedad. En Silicon Valley, solo el 2% de las inversiones para negocios de tecnologías son otorgadas a mujeres, y solo el 20% de la fuerza laboral técnica de las grandes compañía de tecnología, son mujeres.

En el futuro, todos tendremos un robot personal, y nuestra relación de dependencia hacia estos será muy parecida a la que tenemos hoy con los smartphones. Entonces, ¿qué tipo de robots tendremos en casa? Cuando Apple lanzó el software de reconocimiento de voz Siri, este podía ayudarte si sufrías un ataque cardíaco, pero si le decías que fuiste violada, Siri respondía: «No sé a qué te refieres». No obstante, Siri era muy útil si necesitabas prostitutas o un proveedor de Viagra.

Shirley Saenz (ella/she)

CEO - Cross-Cultural, Diversity, Equity and Inclusion Expert

Shirley es la Directora de Iceberg y Expert Panelist de los Global, Diversity, Equity & Inclusion Benchmarks (GDEIB). Cuenta con más de 12 años de experiencia en el mundo corporativo y en 10 países de América Latina. Certificada en liderazgo inclusivo, inteligencia cultural, y benchmarks globales de DEI. Shirley tiene un profundo conocimiento de la diversidad cultural de América Latina y experiencia suficiente facilitando conversaciones estratégicas en DEI con niveles directivos y de liderazgo.